5 月 1 日消息,微軟昨日(4 月 30 日)發(fā)布 Phi-4-reasoning 系列推理模型,通過監(jiān)督微調(diào) Phi-4,并利用 o3-mini 生成的高質(zhì)量“可教導(dǎo)”提示數(shù)據(jù)集訓(xùn)練,專為復(fù)雜推理任務(wù)設(shè)計。

IT之家援引博文介紹,微軟本次共推出 Phi-4-reasoning、Phi-4-reasoning-plus 和 Phi-4-mini-reasoning 三款模型,官方稱該系列模型不僅延續(xù)了小型模型的高效特性,還在推理能力上實現(xiàn)重大突破。

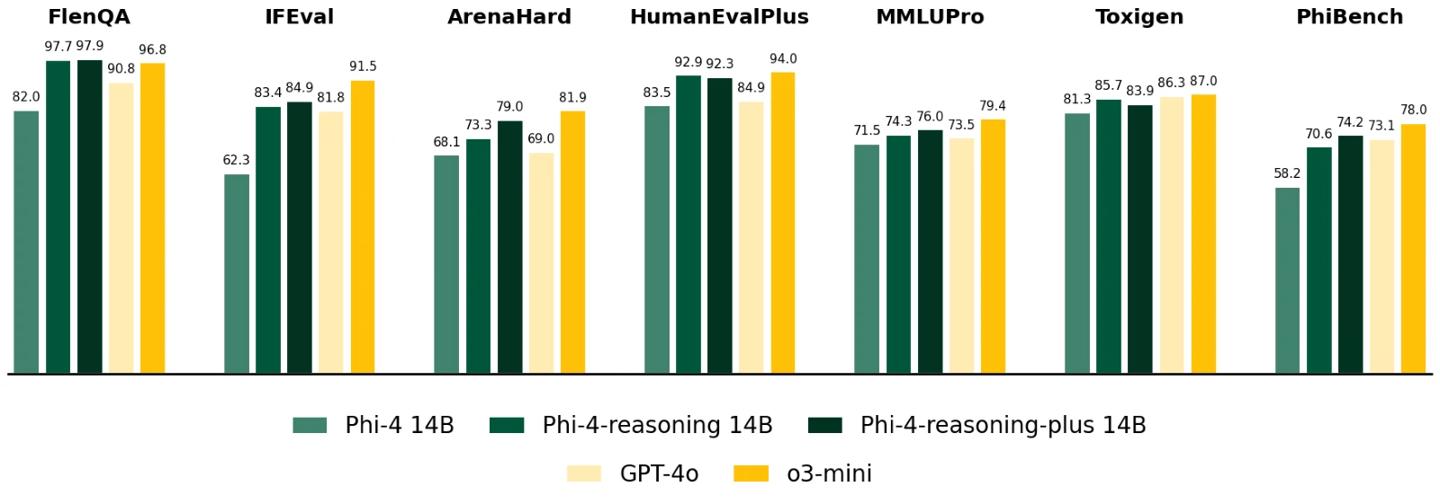

該系列模型通過推理時間擴展(inference-time scaling)技術(shù),擅長處理需要多步驟分解和內(nèi)部反思的復(fù)雜任務(wù),尤其在數(shù)學(xué)推理和代理型應(yīng)用中表現(xiàn)突出,具備媲美大型前沿模型的潛力。

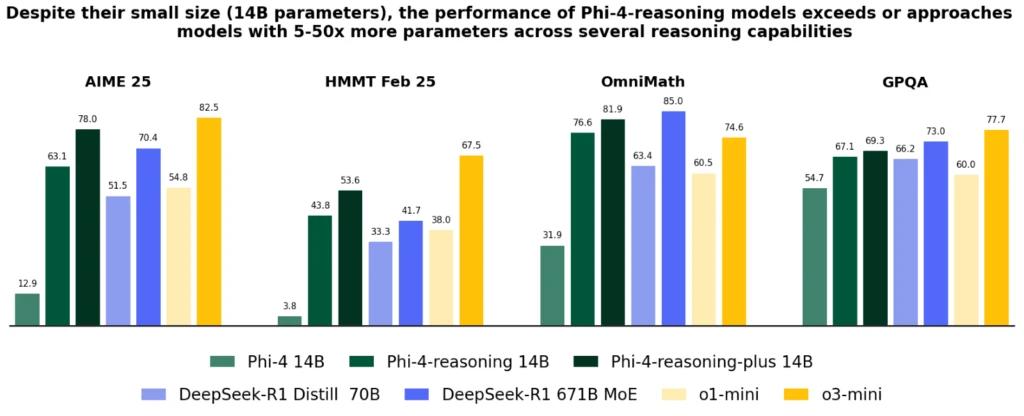

Phi-4-reasoning 是一款擁有 140 億參數(shù)的開源推理模型,通過監(jiān)督微調(diào)(Supervised Fine-Tuning,SFT)Phi-4,結(jié)合 OpenAI o3-mini 的高質(zhì)量推理演示數(shù)據(jù),并充分利用額外計算資源,生成詳細(xì)的推理鏈條。

Phi-4-reasoning-plus 增強版通過強化學(xué)習(xí)(Reinforcement Learning,RL)進一步提升性能,tokens 用量比標(biāo)準(zhǔn)版多 1.5 倍,支持更高精度。

兩款模型在數(shù)學(xué)推理和博士級科學(xué)問題測試中,均超越 OpenAI o1-mini 和

DeepSeek-R1-Distill-Llama-70B,甚至在 AIME 2025(美國數(shù)學(xué)奧林匹克資格賽)中擊敗 6710 億參數(shù)的 DeepSeek-R1 滿血模型。

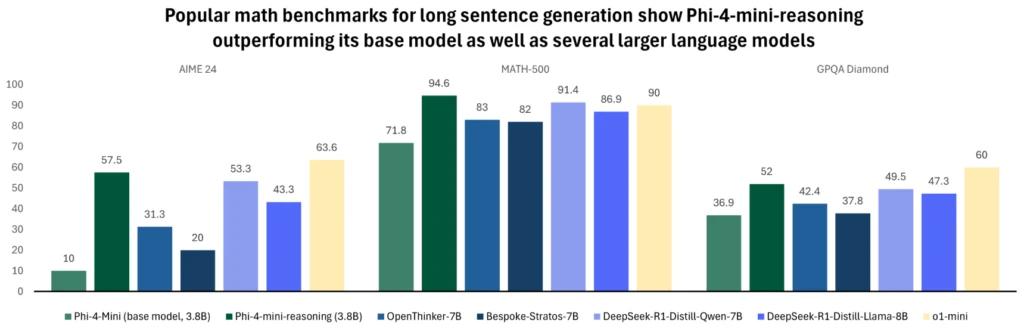

Phi-4-mini-reasoning 專為計算資源有限的環(huán)境設(shè)計,是一款基于 Transformer 的緊湊型語言模型,優(yōu)化用于數(shù)學(xué)推理。